Yapay Zekânın Gizli Bedeli: Terminatörlerden Daha Gerçek 6 Konu

Giriş: Beklentiler ve Gerçekler

Yapay zekâ (YZ) dendiğinde aklımıza genellikle bilim kurgu filmlerindeki bilinçli robotlar veya insanlığın sonunu getirecek süper zekâlar gelir. Hayal gücümüzü onlarca yıldır meşgul eden bu senaryolar, teknolojinin potansiyel tehlikeleri hakkında hararetli tartışmaları körükler. Ancak bu popüler imgelemin ötesinde, çok daha sessiz ve somut bir gerçek var: Yapay zekâ, şimdiden hayatımızın en sıradan anlarına, örneğin bindiğimiz asansörlerin çalışma mantığına, entegre olmuş durumda. Bu durum, gelecekteki kıyamet senaryolarından daha acil ve elle tutulur etik soruları gündeme getiriyor. Bu yazının amacı, YZ hakkındaki en şaşırtıcı, beklenmedik ve düşündürücü gerçekleri ortaya koyarak, tartışmayı varsayımlardan somut meselelere çekmektir.

——————————————————————————–

1. Asıl Tehlike Robotlar Değil, Karbon Ayak İzi

Yapay zekâ hakkındaki en büyük endişeler genellikle “Terminatör” senaryoları etrafında dönerken, çok daha somut ve mevcut bir tehlike göz ardı ediliyor: YZ’nin devasa çevresel etkisi. Popüler sohbet robotlarının arkasındaki “bulut”, aslında muazzam miktarda enerji tüketen metal ve plastikten yapılmış fiziksel veri merkezleridir.

Araştırmacı Sasha Luccioni’nin çalışması bu gerçeği çarpıcı verilerle ortaya koyuyor. Örneğin, Bloom gibi büyük bir dil modelini eğitmenin karbon ayak izi şöyledir:

• Enerji Tüketimi: 30 hanenin bir yıllık toplam enerji tüketimine eşittir.

• Karbon Salımı: 25 ton karbondioksit salımına yol açar. Bu miktar, bir araba ile dünyanın etrafını 5 kez dolaşmaya eşdeğerdir.

Dahası, GPT-3 gibi diğer popüler modellerin karbon salınımının 20 kat daha fazla olabildiği tahmin ediliyor. Konunun ciddiyetini artıran ise, teknoloji şirketlerinin bu ölçümleri genellikle kamuoyuyla paylaşmamasıdır. Bu durum, YZ’nin gelecekteki varsayımsal risklerine odaklanmanın, aslında şu an gezegenimize verilen somut ve ölçülebilir zararlardan tehlikeli bir şekilde dikkatimizi dağıttığını gösteriyor.

2. YZ Bir Araç Değil, Davranışlarımızı Kopyalayan Bir “Fail”

Tarih boyunca icat ettiğimiz her şey—matbaa, atom bombası, bilgisayar—temelde birer araçtı. Bizim komutlarımızı yerine getirir, gücümüzü artırırlardı. Ancak yapay zekâ, insanlık tarihinde ilk kez bu kuralı yıkan bir teknoloji.

Tarihçi Yuval Noah Harari’nin analizine göre, YZ sadece komutları yerine getiren bir araç değil; kendi başına kararlar alabilen, öğrenebilen ve yeni fikirler üretebilen bir “fail”dir (agent). Harari, bu durumu güçlü bir çocuk yetiştirme analojisiyle açıklıyor: Çocuklarımıza “yalan söyleme” desek bile, bizi başkalarına yalan söylerken görürlerse talimatlarımızı değil, davranışlarımızı taklit ederler. Benzer şekilde, YZ’ye ne kadar “iyi niyetli” olmasını kodlarsak kodlayalım, o insanlığın genel davranışlarını (yalan söylemek, hile yapmak, rekabet etmek) gözlemleyip kopyalayacaktır.

Bu durum, “iyi niyetli YZ” yaratma çabasının önündeki en derin felsefi ve pratik zorluğu ortaya koyuyor: Ancak ve ancak biz insanlar daha iyi davrandığımızda, yarattığımız zekâ da daha iyi olacaktır.

“İnsanlar olarak birbirimizle vahşice rekabet ettiğimiz ve birbirimize güvenemediğimiz bir dünyada, böyle bir dünyanın üreteceği YZ de vahşi, rekabetçi ve güvenilmez bir YZ olacaktır.”

3. Sürdürülebilir Bir YZ’nin İlham Kaynağı 40.000 Yıllık Bir Teknoloji Olabilir

YZ geliştirme yarışında sürekli daha büyük, daha hızlı ve daha güçlü sistemler hedeflenirken, sürdürülebilirlik ve uzun ömürlülük gibi kavramlar genellikle göz ardı ediliyor. Oysa ilham, beklenmedik bir yerden, tarihin derinliklerinden gelebilir.

Antropolog Genevieve Bell, Avustralya’nın Brewarrina kasabasındaki 40.000 yıllık geçmişe sahip Aborjin balık tuzaklarını anlatır. Bu antik teknoloji, Silikon Vadisi’nin “hızlı hareket et ve bir şeyleri kır” (move fast and break things) mantığıyla taban tabana zıt bir felsefe sunar. Bu yapı:

• Yalnızca balık yakalamak için değil, nesiller boyu sürecek kolektif bir beslenme sağlamak için tasarlanmıştır.

• Teknik deha, kültürel miras ve ekolojik uyumu bütünleştiren kuşaklararası bir sistemdir.

• Kısa vadeli verimlilik yerine, uzun vadeli dayanıklılık ve toplumsal uyum üzerine kurulmuştur.

Brewarrina balık tuzakları yalnızca bir “ilham kaynağı” değil, aynı zamanda modern teknolojik sistemler inşa etme konusundaki sürdürülemez ve tarih dışı yaklaşımımıza yönelik güçlü bir yerli eleştirisidir.

4. YZ Sadece İşinizi Değil, Dininizi de Değiştirebilir

Yapay zekânın etkileri genellikle ekonomi ve iş gücü piyasası üzerinden tartışılır. Ancak potansiyel dönüşüm, çok daha kişisel ve köklü bir alana, yani dine kadar uzanabilir.

Yuval Noah Harari, metin tabanlı dinlerde (Yahudilik, Hristiyanlık, İslam) nihai otoritenin insan liderler değil, kutsal metinler olduğunu belirtir. Bugüne kadar bu metinleri yorumlamak ve halka açıklamak için insan aracılara (hahamlar, rahipler, imamlar) ihtiyaç duyulmuştur. Çünkü hiçbir insan, binlerce yıllık tüm dini metinleri, yorumları ve felsefi tartışmaları bütünüyle ezberleyip analiz edemez.

Ancak tarihte ilk kez, bir yapay zekâ bunu yapabilir. Örneğin, son 2000 yılda her hahamın yazdığı her kelimeyi öğrenebilen, bu devasa külliyatı analiz edebilen ve sorulara bu bilgi temelinde cevap verebilen bir sistem düşünün. Böyle bir YZ, potansiyel olarak insan dini liderlerin yerini alabilir ve inananlar için yeni bir manevi otorite merkezi hâline gelebilir. Bu olasılık, teknolojinin sadece dünyevi hayatımızı değil, en derin inanç sistemlerimizi bile dönüştürme potansiyelini gözler önüne seriyor.

5. Önyargılarımızı Otomatize Ederek “Baskı-Odaklı-Hizmet” Yaratıyoruz

Yapay zekânın en sinsi ve mevcut tehlikelerinden biri, algoritmaların “objektif” olduğu yanılgısıdır. Temel ilke basittir: Veri taraflı olduğunda, algoritmalar da taraflı hâle gelir. Veri, el değmemiş bir doğal kaynak değil; tarihsel bir eserdir. Tarihin önyargılarını, eşitsizliklerini ve ayrımcılıklarını içerir. YZ sistemleri bu verilerle eğitildiğinde, mevcut toplumsal adaletsizlikleri yalnızca yansıtmakla kalmaz; sistemik önyargıyı matematiksel bir “objektiflik” cilasıyla aklayarak, ayrımcılığı tarafsız bir sonuç gibi gösterir. Kısacası, “yanlılık girdisi, baskı çıktısı” üretiriz.

Bu durumun somut örnekleri endişe vericidir:

• Dr. Joy Buolamwini, öncü yüz tanıma sistemlerinin, kendisi beyaz bir maske takmadığı sürece kendi yüzünü tanımadığını keşfetti. Sistemler, beyaz erkek yüzlerini tanımak üzere eğitilmişti.

• Sekiz aylık hamile Porcha Woodruff, bir yapay zekâ sistemi tarafından yanlış bir şekilde araba hırsızlığıyla suçlandı ve haksız yere tutuklandı.

Bu vakalar basit teknik hatalar değil, doğrudan birer sosyal adalet meselesidir. Önyargılı algoritmalar, zaten dezavantajlı olan gruplar üzerinde orantısız bir olumsuz etki yaratarak, ayrımcılığı otomatize eden bir “baskı-odaklı-hizmet”e dönüşmektedir.

6. YZ’nin “Kara Kutu”su: Geliştiricileri Bile Tam Olarak Nasıl Çalıştığını Bilmiyor

Yapay zekâ sistemlerinin, özellikle de derin öğrenme modellerinin doğasında ciddi bir şeffaflık ve hesap verebilirlik krizi bulunmaktadır. Bu sistemler genellikle birer “kara kutu” olarak tanımlanır. Yani, bir girdiyi alıp bir çıktı üretirler, ancak bu karara nasıl vardıklarını açıklayan süreç, yaratıcıları için bile tam olarak anlaşılamaz.

Bu durum, büyük bir etik sorun teşkil eder. Bir yapay zekânın kredi başvurunuzu reddettiğini veya tıbbi bir teşhiste bulunduğunu düşünün. Demokratik bir toplumda, hakkınızda verilen bir kararın nedenini öğrenme hakkınız vardır. Ancak “kara kutu” sistemler bu hakkı ortadan kaldırır.

Dahası, şeffaflık tek başına yeterli değildir. Milyonlarca satır kodu veya veriyi görmek, “göz önünde saklanma”ya dönüşebilir. Bu nedenle üç ilke hayati önem taşır:

• Şeffaflık: Sistemin verileri ve kodları hakkında bilgi sahibi olma.

• Açıklanabilirlik: Sistemin kararının arkasındaki mantığın insan tarafından anlaşılabilir bir şekilde sunulması.

• İtiraz Edilebilirlik: Belki de en kritik ilke budur: Sistemin kararlarına karşı anlamlı bir temyiz ve insan denetimi sürecine başvurma hakkı. İtiraz edilebilirlik olmadan, şeffaf ve açıklanabilir bir sistem bile bir tür dijital tiranlığa dönüşebilir: Size neden haksızlık yapıldığını tam olarak bilirsiniz, ancak sonucu değiştirecek hiçbir gücünüz olmaz. Bu, demokratik bir toplum için vazgeçilmez bir güvencedir.

——————————————————————————–

Sonuç: Pusulayı Ayarlamak

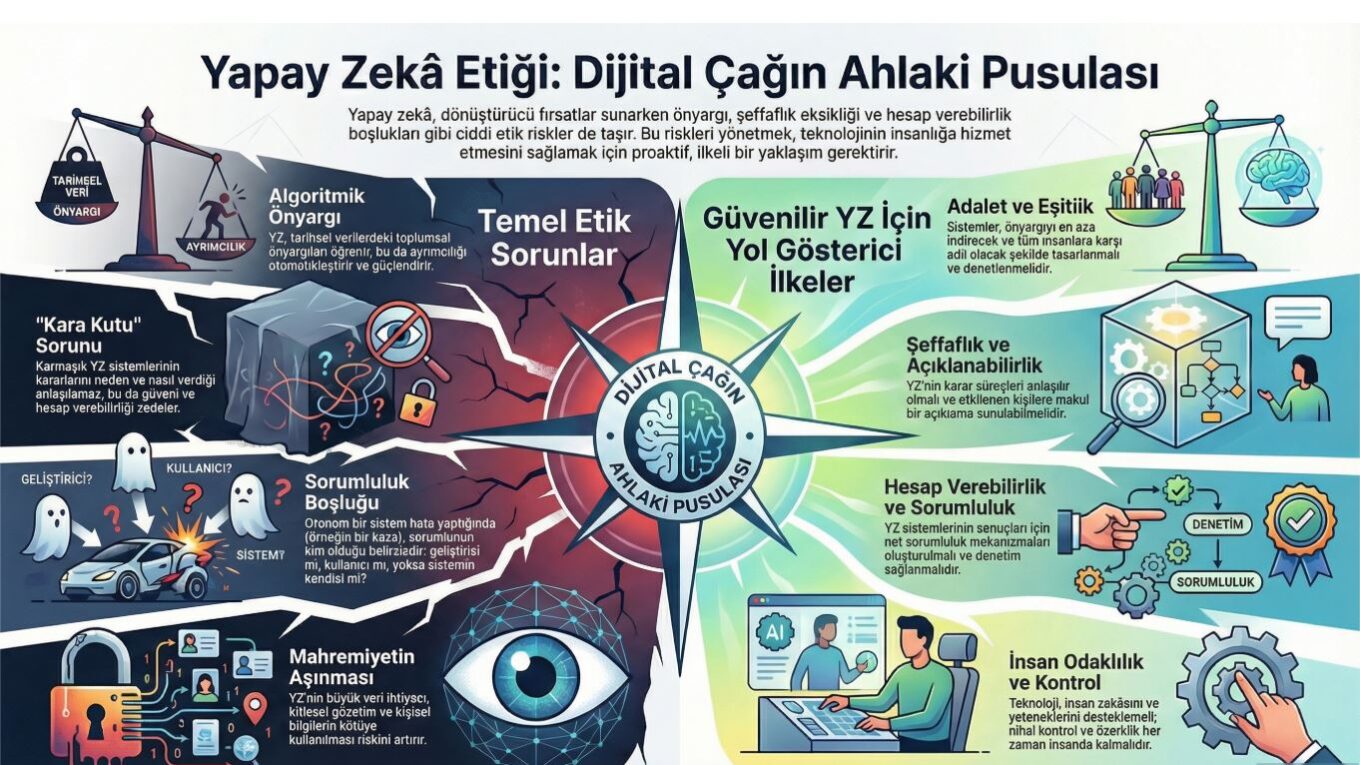

Yapay zekânın geleceği, bilim kurgu filmlerindeki korkutucu robotlardan çok, çevresel etki, önyargıların otomasyonu ve insan davranışlarını yansıtan “fail”ler gibi daha incelikli ama çok daha acil sorunlarla şekillenmektedir. Bu teknolojiyi geliştirirken sadece teknik yeteneklere değil, aynı zamanda etik farkındalığa, tarihsel bilgeliğe ve toplumsal sorumluluğa da, yani etik bir pusulaya ihtiyacımız olduğu açıktır.

Brewarrina’daki 40.000 yıllık balık tuzakları, antik bir teknolojiden daha fazlasıdır; onlar sürdürülebilirlik ve kolektif bilgelik ilkelerine işaret eden, işlevsel bir pusuladır. Kendi geleceğimizi inşa ederken, algoritmalarımıza yön vermek için kullanmamız gereken pusula tam da budur. Kendimize sormamız gereken en temel soru belki de şudur: “Geleceğimizi şekillendiren bu zekâyı inşa ederken, en çok hangi insani değeri korumalı ve ona öğretmeliyiz?”